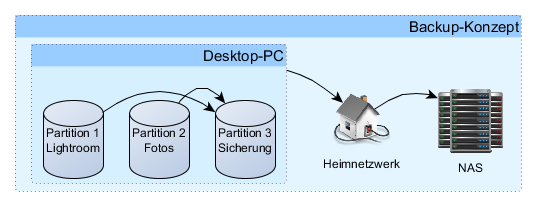

In Datensicherung für Fotografen habe ich bereits ausführlich beschrieben, warum man Backups machen sollte und wie die üblichsten Techniken funktionieren. Wie es immer so ist, wenn man Wasser predigt und Wein trinkt, ist mir kurz nach diesem Artikel eine Festplatte kaputt gegangen und ich habe selbst einige Daten verloren. Meine älteren Fotos waren durch einen glücklichen Zufall gesichert, aber von anderen Daten auf der Festplatte gab es kein Backup. Die Platte war eigentlich völlig intakt, aber inzwischen ca. 2 Jahre nicht mehr in Betrieb gewesen. Das reichte, um die Technik außer Gefecht zu setzten: die Festplatte wurde vom Computer gar nicht erst erkannt. Auch wenn wahrscheinlich keine "lebenswichtigen" Daten betroffen sind, hat mir dieser Vorfall noch einmal die Dringlichkeit einer vernünftigen Sicherung vor Augen geführt. Deshalb habe ich mir die Zeit genommen, selbst Komponenten für ein NAS-System auszusuchen und einen zuverlässigen Netzwerkspeicher zu bauen. In diesem Artikel möchte ich also konkret auf meine umgesetzte Lösung eingehen und Interessierten eine Nachbauanleitung zur Verfügung stellen.

Warum überhaupt Selbstbau?

Natürlich gibt es von erfahrenen Herstellern wie Synology oder Qnap fertige NAS-Systeme zu kaufen. Die Geräte sind fire-and-forget-Lösungen, die man im Prinzip nur auspackt, anschließt und dann loslegen kann. Trotzdem habe ich mich entschieden, meine eigene maßgeschneiderte Lösung zu bauen. Dadurch erhalte ich die volle Kontrolle und die freie Wahl aller Einzelkomponenten und kann eine beliebige freie Software auf meinem Gerät einsetzen. Einige fertige NAS-Lösungen kann man zwar ebenfalls mit alternativen Betriebssystemen betreiben, aber da ich hier wenig Erfahrung habe, wollte ich mich darauf nicht unbedingt verlassen müssen.

Kostentechnisch bin ich ungefähr auf dem gleichen Niveau wie mit einem fertigen NAS-System - wenn man davon absieht, dass ich einige Stunden in die Auswahl der Komponenten gesteckt habe.

Die Komponenten

Mainboard & Prozessor

Ich hatte mir im Vorfeld überlegt, welche Anforderungen ich an mein Mainboard stelle. Ich wusste bereits, dass ich mindestens vier SATA III Anschlüsse für die Festplatten und mindestens einen USB 3.0 Anschluss für den USB-Stick mit dem Betriebssystem brauchen würde. Die Netzwerkanbindung sollte über Gigabit Ethernet passieren. Außerdem sollte sich natürlich der Stromverbrauch in Grenzen halten. Ursprünglich wollte ich noch einen Prozessor, der das AES-Instructionset (AES-NI) unterstützt, das bei Verschlüsselungsoperationen einen deutlichen Performancevorteil bringt. Diese letzte Anforderung habe ich aber wieder verworfen, weil AES-NI nur von einigen wenigen Intel Atom Prozessoren unterstützt wird. Offenbar ist es aber unmöglich, ein Board mit Atom-Prozessor zu finden, das mindestens vier SATA III Geräte ansprechen kann. Dazu müsste man in höhere Prozessorklassen wie Pentiums, Celerons oder Intel i3 gehen, die dann aber schnell mehr kosten, als ich eigentlich ausgeben wollte. Ich habe deshalb stattdessen ASUS E2KM1I-Deluxe Board im Mini-ITX Formfaktor gekauft, das mit einer AMD APU E2-2000 ausgestattet ist und bis zu 16 GB RAM unterstützt. Die thermische Verlustleistung des Prozessors liegt zwar mit 18 Watt etwas höher, als ich eigentlich gehen wollte, aber dafür werden alle wichtigen Features unterstützt und das System bekommt ordentlich Leistung. Der angenehme Nebeneffekt dieser Wahl ist, dass der Prozessor mit dem Prozessor in meinem derzeitigen Netbook verwandt ist und ich so die Leitung recht gut abschätzen kann.

Der Faustregel folgend, dass man für jedes Terabyte an Festplattenspeicher mindestens ein Gigabyte an RAM verbauen sollte, habe ich 8 GB DDR3-1333 RAM DIMMs gekauft. An dieser Stelle möchte ich darauf hinweisen, dass Asus eine Liste mit unterstützten RAM-Typen veröffentlicht hat, nach der man sich richten sollte, wenn man später keine Probleme mit dem Gerät haben möchte. Wer mehr Performance haben möchte, sollte in erster Linie den RAM erweitern. ZFS ist überaus speicherhungrig und meine 8 GB stellen gerade eben die Untergrenze dessen dar, was man dem System zur Verfügung stellen sollte.

Festplatten

Bei den Festplatten habe ich mich für Western Digital Red 3TB, 3.5", SATA 6Gb/s (WD30EFRX) entschieden. Diese Platten sind für den Dauereinsatz in NAS-Systemen ausgelegt und mit maximal 4,4 Watt Verlustleistung unter Volllast besonders energiesparend. Sie drehen mit 5.400 U/min, haben große 64 MB Cache und sind mit einer MTBF (mittlere Betriebsdauer zwischen Ausfällen) von einer Million Stunden angegeben. Zum Vergleich: normale Desktopfestplatten halten höchstens halb so lange, Western Digital Green Festplatten sogar nur ein Drittel so lange. Damit werden die WD Red den besonderen Anforderungen an die Zuverlässigkeit in einem NAS-System gerecht.

Ein kleiner Tipp noch: um dem gleichzeitigen Ausfall zu vieler Platten vorzubeugen, sollte man möglichst Festplatten aus unterschiedlichen Produktionschargen verwenden. Das schafft man z. B., indem man einen Teil der Platten bei einem anderen Händler bestellt.

Gehäuse

Bereits vor einigen Monaten habe ich mir ein neues Gehäuse für meinen Desktop-PC gekauft. Der schwedische Hersteller Fractal Design bietet wunderschöne, minimalistische Gehäuse mit Kabelmanagement und effektiver Geräuschdämmung mittels Bitumenplatten an. Begeistert von diesem Gehäuse habe ich auch bei meinem NAS wieder zu Fractal Design gegriffen. Diesmal fiel meine Wahl auf das Fractal Design Node 304 in schwarz im Mini-DTX/Mini-ITX-Formfaktor. Es bietet genügend Platz für mein Board, verfügt über drei Gehäuselüfter und kann bis zu sechs Festplatten aufnehmen - genug Raum für Erweiterungen also.

Es gibt für NAS-Systeme zwar auch eigene spezialisierte Gehäuse mit sogenannten Backplanes, die bereits die Festplattencontroller und die komplette Rechentechnik enthalten und einen Festplattentausch im laufenden Betrieb ermöglichen, aber diese Gehäuse sind in meine Größenvorstellungen schon so teuer, dass ich mich dagegen entschieden habe.

Netzteil

Die Wahl eines passenden Netzteils war eine besondere Hürde. Einerseits wird mein System auch unter Last wenig Strom verbrauchen, andererseits sind die meisten Netzteile für ausgewachsene Desktop-PCs dimensioniert.

Der Markt für Netzteile um die 200 Watt oder weniger ist also eher überschaubar. Dazu kommt, dass ich aus Effizienzgründen ein Netzteil einbauen wollte, das eine möglichst hohe 80+ Spezifizierung hat. Solche Netzteile bieten auch bei niedrigerem Stromverbrauch gute Effizienzwerte. Leider bietet das Gehäuse nur maximal 160mm Platz für ein Netzteil, so dass einige in Frage kommende 80+ Gold zertifizierte Netzteile schlicht wegen ihrer Größe aussortiert werden mussten.

Ich habe letztlich eine Kompromisslösung gewählt und das be quiet! Pure Power L8 350W ATX 2.4 (BN221) gekauft, das zumindest eine 80+ Bronze Zertifizierung hat.

Betriebssystem

Bei der Betriebssystemwahl stand für mich recht früh fest, dass ich das auf FreeBSD basierende FreeNAS verwenden würde. Der Hauptgrund dafür ist, dass FreeNAS von sich aus das Dateisystem ZFS unterstützt. ZFS arbeitet so ähnlich wie RAID, unterstützt und überprüft aber regelmäßig die Checksummen, die es zu den Dateien ablegt, so dass Fehler im Dateisystem behoben werden können. Außerdem ist FreeNAS eine Software, die sich bereits viele Jahre im harten Alltagseinsatz bewährt hat und mir daher ausreichend zuverlässig erscheint. FreeNAS ist zudem offene Software, bei der der Quellcode für jeden frei einsehbar und veränderbar ist. Dadurch bindet man sich nicht an einen Hersteller.

Den mitgelieferten Funktionsumfang kann man mit Plugins erweitern. So lassen sich Streaming Server, BitTorrent-Clients, Newsreader und viele andere nützliche Dinge sehr einfach anbinden.

In meinem speziellen Setup wird FreeNAS von einem USB3.0-Stick laufen, so dass keine Festplatte für das kleine Betriebssystem "verschwendet" wird. Standardmäßig ist die USB3.0-Unterstützung in FreeNAS zwar ausgeschaltet, lässt sich aber mit einem einfachen Schalter auch einschalten. Da auch das Mainboard USB3.0 unterstützt, wird hier die optimale Performance für das Betriebssystem erzielt.

Fazit

Zugegebenermaßen ist der Aufwand für ein Selbstbau-NAS deutlich höher als für eine Fertiglösung. Dafür erhält man aber auch ein System, das man frei nach den eigenen Wünschen gestalten, konfigurieren und ausstatten kann - für mich auf jeden Fall ein lohnenswerter Kompromiss.

Komponentenliste

Hier nochmal alle Komponenten, die man braucht, um das Ganze selbst nachzubauen:

- ASUS E2KM1I-Deluxe

- 4x Western Digital Red 3TB, 3.5", SATA 6Gb/s (WD30EFRX)

- Fractal Design Node 304

- be quiet! Pure Power L8 350W ATX 2.4 (BN221)

- 2x 4GB Corsair XMS3 DDR3-1333 DIMM CL9 Single

- 4x SATA III Kabel

- 1x USB 3.0 Stick (USB 4GB 16/90 ExpressST1 bk U3 STL)

Du musst angemeldet sein, um kommentieren zu können.